چکیده: با تبدیل شدن هوش مصنوعی (AI) به محرکی اساسی برای نوآوری و کارایی در صنایع مختلف، سازمانها با فشارهای فزایندهای برای مدیریت مسئولانه این سیستمها روبرو هستند. این مقاله سفید به بررسی نقش چارچوب COBITبه عنوان یک راه حل قوی و سازگار برای حکمرانی و مدیریت مؤثر هوش مصنوعی میپردازد. COBIT که به طور سنتی برای حکمرانی بر اطلاعات و فناوری (I&T) استفاده میشود، در موقعیتی منحصر به فرد قرار دارد تا چالشهای متمایز ایجاد شده توسط سیستمهای هوش مصنوعی، از جمله مسائل مربوط به اخلاق، پاسخگویی، شفافیت و انطباق را برطرف کند. رویکرد ساختاریافته این چارچوب، یک مدل جامع و مبتنی بر چرخه حیات را ارائه میدهد که سازمانها را در نحوه همسوسازی ابتکارات هوش مصنوعی با اهداف استراتژیک تجاری، بهینهسازی تخصیص منابع و کاهش ریسکهای خاص هوش مصنوعی راهنمایی میکند.

نقش هوش مصنوعی در سازمانهای مدرن

همزمان با ادغام هر چه بیشتر هوش مصنوعی در سازمانهای مدرن، نیاز به حکمرانی و مدیریت قوی هوش مصنوعی افزایش یافته است. بسیاری از سازمانها از یادگیری ماشین (ML)، یادگیری عمیق (DL) و هوش مصنوعی مولد برای سادهسازی عملیات از طریق اتوماسیون، بهبود تصمیمگیری و ارتقای تجربه مشتری/ کاربر استفاده میکنند. سیستمهای هوش مصنوعی، چه در خودکارسازی فرآیندهای خدمات مشتری/کاربر و چه در تولید تحلیلهای پیشبینیکننده، فرصتهای جدیدی را برای کارایی و نوآوری ارائه میدهند.

با این حال، استقرار هوش مصنوعی چالشهای منحصربهفردی را نیز به همراه دارد که نیازمند حکمرانی دقیق است. بر خلاف سیستمهای فناوری اطلاعات سنتی، هوش مصنوعی نگرانیهای اخلاقی در مورد سوگیری، انصاف و شفافیت را مطرح میکند که باید در حوزههای قضایی و صنایع مختلف مدیریت شوند. با پیشرفت سریع هوش مصنوعی، سرعت نوآوری اغلب از توانایی پیشبینی کامل اثرات و پیامدهای آن فراتر میرود و سیستمهای هوش مصنوعی را در برابر تهدیداتی مانند دستکاری، مسمومیت دادهها، حملات سایبری و نقضهای امنیتی آسیبپذیر میکند.

بر خلاف سیستمهای فناوری اطلاعات سنتی، هوش مصنوعی نگرانیهای اخلاقی در مورد سوگیری، انصاف و شفافیت را مطرح میکند که باید در حوزههای قضایی و صنایع مختلف مدیریت شوند. با پیشرفت سریع هوش مصنوعی، سرعت نوآوری اغلب از توانایی پیشبینی کامل اثرات و پیامدهای آن فراتر میرود و سیستمهای هوش مصنوعی را در برابر تهدیداتی مانند دستکاری، مسمومیت دادهها، حملات سایبری و نقضهای امنیتی آسیبپذیر میکند.

علاوه بر این، مدیریت باید آگاه باشد که ویژگیهای هوش مصنوعی در برنامههای نرمافزاری تجاری و موتورهای جستجوی متداول که احتمالاً در حال حاضر در سازمان مورد استفاده قرار میگیرند، تعبیه شدهاند. عدم مالکیت روشن بر حکمرانی هوش مصنوعی، این مسائل را تشدید میکند و اغلب منجر به نظارت پراکنده و دشواری در همسویی سیستمهای هوش مصنوعی با استراتژی کلی کسبوکار سازمان میشود.

سیستمهای هوش مصنوعی و اهمیت استراتژیک

سیستمهای هوش مصنوعی شامل چندین فناوری کلیدی هستند که هر کدام قابلیتهای منحصر به فردی دارند که به طور استراتژیک در صنایع مختلف مشارکت میکنند. به عنوان مثال، یادگیری ماشین (ML) شامل آموزش الگوریتمها بر روی دادهها برای تشخیص الگوها و پیشبینی است. در شرکتها، ML میتواند برای پیشبینی تقاضا، تشخیص تقلب و بازاریابی هدفمند استفاده شود و در نهایت منجر به بهبود تصمیمگیری شود.

یادگیری عمیق (DL)، زیرمجموعهای از ML، از شبکههای عصبی با لایههای زیاد برای تجزیه و تحلیل مجموعههای دادههای عظیم و پیچیده استفاده میکند. DL امکان تشخیص پیشرفته تصویر، پردازش زبان طبیعی و سیستمهای خودمختار را فراهم میکند که همگی تأثیر قابل توجهی بر تشخیص، تجزیه و تحلیل و اتوماسیون گردش کار دارند.

علاوه بر این، مدلهای هوش مصنوعی مولد، از جمله شبکههای مولد تخاصمی (GANs) و مدلهای زبان بزرگ (LLMs)، متن، تصاویر یا شبیهسازیهای واقعی ایجاد میکنند که مشابه دادههای ورودی ارائه شده هستند. کسبوکارها اغلب از هوش مصنوعی مولد برای تولید محتوا، تجربیات شخصیسازیشده و نمونهسازی سریع استفاده میکنند.

اهمیت استراتژیک هوش مصنوعی میتواند بر اساس صنعت متفاوت باشد. در مراقبتهای بهداشتی، هوش مصنوعی میتواند تشخیص را بهبود بخشد، برنامههای درمانی شخصیسازیشده را فعال کند و کشف دارو را تسریع کند، که همگی نتایج بیماران را بهبود میبخشند و هزینهها را کاهش میدهند. در صنعت مالی، هوش مصنوعی میتواند معاملات را خودکار کند، قابلیتهای تشخیص تقلب را افزایش دهد و عملیات مالی را متحول کند تا آنها را سریعتر، ایمنتر و دادهمحورتر کند. هوش مصنوعی همچنین میتواند تعمیر و نگهداری پیشبینیکننده را برای بهینهسازی خطوط تولید، بهبود کنترل کیفیت و مدیریت لجستیک زنجیره تامین برای سازمانهای تولیدی انجام دهد. علاوه بر این، هوش مصنوعی میتواند با شخصیسازی تعاملات مشتری، مدیریت موجودی، پیشبینی تقاضا، افزایش فروش و بهبود تجربه مشتری، از صنعت خردهفروشی پشتیبانی کند.

با توجه به پتانسیل هوش مصنوعی برای تأثیرگذاری مستقل بر عملیات، مدیریت دادههای حساس و تأثیرگذاری بر تجربیات مصرفکننده در مقیاس بزرگ، چارچوبهای حاکمیتی تخصصی حیاتی هستند. حاکمیت مؤثر هوش مصنوعی تضمین میکند که سیستمهای هوش مصنوعی با اخلاق سازمانی و اجتماعی همسو هستند، از حریم خصوصی دادهها محافظت میکنند و انطباق را حفظ میکنند، در حالی که ریسکهای منحصر به فرد مرتبط با این سیستمهای خودمختار را مدیریت میکنند.

خطرات و چالشهای سیستمهای هوش مصنوعی

برای دستیابی به مزایای هوش مصنوعی، سازمانها باید خطرات و چالشهای آن را مدیریت کنند. اولاً، سوگیری هوش مصنوعی در مدلها میتواند ناشی از استفاده از دادههایی باشد که ممکن است منعکس کننده نابرابریهای سیستمی یا تاریخی یا سوگیریهای انسانی باشد. اگر سوگیری هوش مصنوعی کنترل نشود، میتواند منجر به شیوههای تبعیضآمیز شود که پیامدهای قانونی دارد، به ویژه در کاربردهای حساسی مانند استخدام یا وامدهی. به عنوان مثال، در پرونده ساس علیه میجر، لیندزی و آفریقا LLC، شاکی ادعا کرد که سوگیری الگوریتمی این شرکت منجر به حذف او از فرصتهای شغلی شده است. همچنین، در فرانسه پروندهای وجود داشت که در آن الگوریتمهای طراحیشده برای شناسایی افرادی که احتمالاً مرتکب تقلب در رفاه میشوند، منجر به اتهاماتی مبنی بر تبعیض علیه افراد با درآمد کم شد. کاهش این خطر مستلزم آزمایش عمدی سوگیری و ممیزی منظم دادههای آموزشی و رفتار مدل است.

علاوه بر این، بسیاری از مدلهای هوش مصنوعی، بهویژه در زمینه یادگیری عمیق، بهعنوان "جعبه سیاه" عمل میکنند که درک نحوه تصمیمگیری این سیستمها را دشوار میسازد. فقدان شفافیت در این زمینه چالشهایی را برای پاسخگویی ایجاد کرده و اعتماد کاربران، مصرفکنندگان و ذینفعان را کاهش میدهد. بنابراین، استفاده از تکنیکهای هوش مصنوعی قابل توضیح برای روشنسازی منطق مدلها ضروری است و این امر به استفاده مسئولانه از هوش مصنوعی و تطابق با دستورالعملهای نظارتی در حال تحول کمک میکند.ماده 50 قانون هوش مصنوعی اتحادیه اروپا، راهنماییهایی در خصوص انتظارات شفافیت از ارائهدهندگان و بهرهبرداران سیستمهای هوش مصنوعی ارائه میدهد. همچنین، بند 93 این قانون ایجاب میکند که در صورت درخواست، اطلاعات لازم به افرادی که با سیستمهای هوش مصنوعی پرخطر تعامل دارند، افشا شود؛ بهخصوص زمانی که از هوش مصنوعی در فرآیندهای تصمیمگیری، مانند ایمنی، استفاده میشود.

بسیاری از مدلهای هوش مصنوعی، بهویژه در زمینه یادگیری عمیق، بهعنوان "جعبه سیاه" عمل میکنند که درک نحوه تصمیمگیری این سیستمها را دشوار میسازد. فقدان شفافیت در این زمینه چالشهایی را برای پاسخگویی ایجاد کرده و اعتماد کاربران، مصرفکنندگان و ذینفعان را کاهش میدهد. بنابراین، استفاده از تکنیکهای هوش مصنوعی قابل توضیح برای روشنسازی منطق مدلها ضروری است و این امر به استفاده مسئولانه از هوش مصنوعی و تطابق با دستورالعملهای نظارتی در حال تحول کمک میکند.

همچنین، عدم انطباق با مقررات و قوانین حفاظت از دادهها و حریم خصوصی (مانند مقررات عمومی حفاظت از دادههای اتحادیه اروپا [GDPR] یا قانون حریم خصوصی مصرفکننده کالیفرنیا [CCPA]) میتواند منجر به مجازاتهای قانونی و آسیب به شهرت سازمانها شود. به عنوان مثال، کاربران هوش مصنوعی ممکن است بهطور عمدی یا غیرعمدی از طریق استفاده از ChatGPT، اسرار تجاری و سایر داراییهای فکری را به خطر بیندازند. بنابراین، سازمانها باید تکنیکهای حفظ حریم خصوصی مانند ناشناسسازی دادهها و حریم خصوصی دیفرانسیل را برای حفظ انطباق پیادهسازی کنند.

به علاوه، سیستمهای هوش مصنوعی بهویژه در برابر حملات سایبری پیچیده، از جمله حملات خصمانهای که عمدتاً ورودیهای مدل را دستکاری میکنند تا خروجیهای نادرست تولید کنند، آسیبپذیر هستند. به عنوان نمونه، تغییر در چند پیکسل یک تصویر میتواند مدل هوش مصنوعی را فریب دهد و بهطور بالقوه اطلاعات مهم را به اشتباه طبقهبندی کند. این نوع حملات میتواند منجر به درک نادرست از تابلوهای ایست بهعنوان تابلوهای محدودیت سرعت در شبکههای عصبی عمیق شود. همچنین، حملات وارونگی مدل میتوانند خطر استخراج دادههای حساس از مدلهای آموزشدیده را بهدنبال داشته باشند. به همین دلیل، سازمانها باید شیوههای حکمرانی و مدیریت جامع مرتبط با سیستمهای هوش مصنوعی را اتخاذ کنند.

نمونههایی از راهنمایی حاکمیت:

چندین چارچوب، استاندارد، و قانون در حاکمیت هوش مصنوعی برای توجه به استفاده اخلاقی، امنیت، پاسخگویی و انصاف در حال ظهور هستند، از جمله:

- اصول هوش مصنوعی سازمان همکاری و توسعه اقتصادی (OECD) که بر حقوق بشر، ارزشهای دموکراتیک، شفافیت و پاسخگویی در کاربردهای هوش مصنوعی تأکید دارند. این اصول به سازمانها کمک میکنند تا اطمینان حاصل کنند که هوش مصنوعی بهطور مسئولانه و اخلاقی مورد استفاده قرار میگیرد. با همسو کردن ابتکارات هوش مصنوعی با این اصول، کسبوکارها میتوانند اعتماد عمومی را جلب کنند و از مشکلات اخلاقی و حقوقی بالقوه اجتناب نمایند. سیستمهای هوش مصنوعی شفاف که سوگیری را به حداقل میرسانند، میتوانند رضایت مشتری و وفاداری به برند را افزایش دهند. در مقابل، سیستمهایی که نمیتوانند این انتظارات را برآورده کنند، ممکن است به آسیبهای اعتباری، عواقب قانونی یا بررسیهای نظارتی منجر شوند. با این حال، بدون اقدامات اجرایی، پایبندی فقط به تعهد داوطلبانه سازمانی متکی خواهد بود.

- در ایالات متحده، چارچوب مدیریت ریسک هوش مصنوعی (AI RMF) که توسط موسسه ملی استاندارد و فناوری (NIST) توسعه یافته، بر مدیریت ریسکهای سایبری مرتبط با هوش مصنوعی متمرکز شده است. این چارچوب یک رویکرد ساختاریافته برای توسعه سیستمهای هوش مصنوعی امن، مقاوم و مطابق با بهترین شیوههای امنیت سایبری ارائه میدهد. پذیرش NIST AI RMF خطر حملات سایبری یا نقض دادهها را که ممکن است بر سیستمهای هوش مصنوعی سازمان تأثیر بگذارد، کاهش میدهد و بدین ترتیب از زیانهای مالی، آسیبهای اعتباری، عدم رعایت مقررات و بیاعتمادی مشتری جلوگیری میکند.

- ISO/IEC 42001:2023 یک استاندارد جهانی است که بر ایجاد یک سیستم مدیریت هوش مصنوعی (AIMS) متمرکز میشود و شامل الزامات خاصی برای ارزیابی ریسک، شفافیت و حاکمیت دادهها است. این استاندارد بر نیاز به مدیریت ریسک ساختاریافته تأکید کرده و سازمانها را تشویق میکند تا اثرات اجتماعی، زیستمحیطی و حریم خصوصی دادههای سیستمهای هوش مصنوعی خود را تجزیه و تحلیل و مستند کنند. علاوه بر این، ISO/IEC 42001 از فرهنگ بهبود مستمر حمایت میکند و از سازمانها میخواهد که بهطور منظم فرآیندهای هوش مصنوعی خود را بررسی کنند تا با بهترین شیوههای صنعت و انتظارات نظارتی همسو بمانند. با پذیرش این استاندارد، سازمانها میتوانند اعتماد ذینفعان را ایجاد کرده، انطباق را تسهیل کنند و بهطور فعال ریسکهای بالقوه مرتبط با هوش مصنوعی را مدیریت نمایند و خود را به عنوان رهبر در استفاده مسئولانه از هوش مصنوعی معرفی کنند.

- قانون هوش مصنوعی اتحادیه اروپا یک چارچوب نظارتی جامع است که توسط اتحادیه اروپا پیشنهاد شده و سیستمهای هوش مصنوعی را بر اساس سطوح ریسک طبقهبندی میکند و الزامات سختگیرانهای را برای استفاده قابل قبول تعیین میکند. سازمانهایی که از برنامههای هوش مصنوعی پرخطر استفاده میکنند، مانند مواردی که در مراقبتهای بهداشتی یا امور مالی به کار میروند، باید فرآیندهای دقیقی برای انطباق با این الزامات را اجرا کنند. عدم انطباق میتواند منجر به جریمههایی مشابه جریمههای صادر شده تحت قانون GDPR شود.

با همسویی فعال با این راهنماها، شرکتها میتوانند خطر جریمهها را کاهش دهند، شهرت خود را بهعنوان سازمانهایی قابل اعتماد افزایش دهند و به طیف گستردهتری از مشتریان نگران حریم خصوصی دادهها و استفاده اخلاقی از هوش مصنوعی جذب شوند. اگرچه این رویکرد یک چارچوب ساختاریافته برای هوش مصنوعی اخلاقی و مسئولانه ارائه میدهد، ممکن است انعطافپذیری لازم برای فناوریهای سریعالسیر را نداشته باشد.

با همسویی فعال با این راهنماها، شرکتها میتوانند خطر جریمهها را کاهش دهند، شهرت خود را بهعنوان سازمانهایی قابل اعتماد افزایش دهند و به طیف گستردهتری از مشتریان نگران حریم خصوصی دادهها و استفاده اخلاقی از هوش مصنوعی جذب شوند. اگرچه این رویکرد یک چارچوب ساختاریافته برای هوش مصنوعی اخلاقی و مسئولانه ارائه میدهد، ممکن است انعطافپذیری لازم برای فناوریهای سریعالسیر را نداشته باشد.

شکافهای موجود

در حالی که این مثالها مبنای قوی برای حاکمیت هوش مصنوعی فراهم میآورند، شکافهای قابل توجهی همچنان برقرار است. هماهنگی محدود میان کشورهای مختلف منجر به ایجاد مقررات ناهمگون و اجرای متناقض شده است. به عنوان نمونه، قانون هوش مصنوعی اتحادیه اروپا بر روی کنترلهای سختگیرانه و شیوههای مدیریت ریسک برای سیستمهای هوش مصنوعی با ریسک بالا تأکید میکند، در حالی که سایر مناطق ممکن است استانداردهای ملایمتری را اتخاذ کرده یا بهطور کلی فاقد حاکمیت جامع در زمینه هوش مصنوعی باشند.

هماهنگی محدود میان کشورهای مختلف منجر به ایجاد مقررات ناهمگون

و اجرای متناقض شده است.

این تفاوتها چالشهای جدی را برای سازمانهایی که در چندین منطقه فعالیت میکنند، بهوجود میآورد، زیرا آنها ناچارند در یک شبکه پیچیده از مقررات حرکت کنند که ممکن است با یکدیگر در تضاد باشند یا قابلیت همکاری کافی نداشته باشند. رویکردهای نظارتی نامتناسب میتواند منجر به عدماطمینان، پیچیدگی در تلاشهای انطباق و افزایش هزینههای عملیاتی برای کسبوکارهایی شود که باید استراتژیهای حاکمیت هوش مصنوعی خود را با استانداردهای مختلف بینالمللی هماهنگ کنند.

در عین حال، در برخی صنایع خاص نظیر مراقبتهای بهداشتی، پیشرفتهای قابل توجهی در حاکمیت هوش مصنوعی مشاهده شده است. این پیشرفتها ناشی از نیاز حیاتی به تضمین ایمنی بیمار، حفظ حریم خصوصی دادهها و تصمیمگیریهای اخلاقی در برنامههای پزشکی مبتنی بر هوش مصنوعی است. اما در مقابل، بخشهایی مانند امور مالی و آموزش از این تحول عقب ماندهاند و فاقد مدلهای حاکمیتی جامعی هستند که بتوانند ریسکهای ناشی از هوش مصنوعی را در این زمینهها مدیریت کنند. برای مثال، در حوزه آموزش، هوش مصنوعی برای شخصیسازی یادگیری و بهبود کاراییهای اداری به کار میرود، در حالی که استانداردهای حکمرانی برای اطمینان از انصاف، شفافیت و کاهش تعصب همچنان در مراحل ابتدایی توسعه قرار دارند. این عدم توجه به مسائل حاکمیتی به ریسکهای بالقوهای منجر میشود که بیپاسخ باقی میمانند، بهویژه در مورد استفاده اخلاقی، تعصب و امنیت دادهها.

از سوی دیگر، مهمترین شکاف درون سازمانها نهفته است، جایی که غالباً فقدان مالکیت روشن بر حاکمیت هوش مصنوعی وجود دارد.

هیئت مدیره و مدیریت اجرایی باید با مزایا و خطرات هوش مصنوعی آشنا باشند تا نقشهای مسئول و پاسخگو را بهوضوح تعریف کنند و از نظارت پراکنده جلوگیری کنند. این نوع نظارت میتواند توانایی سازمان را در درک تأثیر گستردهتر هوش مصنوعی بر عملیات خود محدود کند.

بدون مالکیت روشن، ذینفعان کلیدی از جمله رهبران فناوری اطلاعات، افسران انطباق و مدیران تجاری ممکن است نتوانند سیستمهای هوش مصنوعی را با سیاستها و استراتژیهای کلی سازمان هماهنگ کنند. این عدمهماهنگی میتواند به پیادهسازیهای نامنظم، نقص در کارایی و درک مبهم از خطرات و فرصتهای مرتبط با استقرار هوش مصنوعی منجر شود.

مروری بر چارچوب COBIT

با ادامه تکامل فناوری هوش مصنوعی، نیاز به چارچوبهای حکمرانی تطبیقی نیز افزایش خواهد یافت. چارچوب COBIT میتواند با ارائه یک رویکرد جامع برای حکمرانی هوش مصنوعی، این شکافها را برطرف کند. هدف اصلی آن کمک به سازمانها برای همسویی فناوری اطلاعات با اهداف تجاری، مدیریت ریسک و اطمینان از استفاده بهینه از منابع است.

COBIT این امر را با ارائه یک چارچوب جامع برای حکمرانی و مدیریت I&T (فناوری اطلاعات و فناوری) محقق میکند. این چارچوب بر مسئولیتپذیری و پاسخگویی تأکید دارد تا به سازمانها کمک کند ارزش سرمایهگذاریهای I&T خود را به منظور کاهش ریسکهای مرتبط بهینه کنند.

حوزهها و اهداف

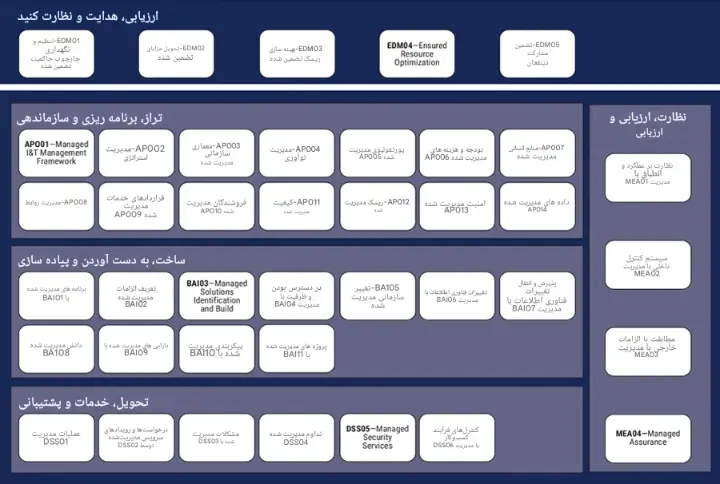

COBIT به پنج حوزه اصلی (شکل 1) تقسیم میشود. این حوزهها شامل 40 هدف هستند که برای مدیریت فعالیتهای مرتبط با فناوری اطلاعات، از برنامهریزی استراتژیک گرفته تا عملیات روزمره و نظارت بر عملکرد، طراحی شدهاند.

شکل 1: حوزههای COBIT

پنج حوزه COBIT عبارتند از:

- ارزیابی، هدایت و نظارت (EDM) - این حوزه عمدتاً بر فعالیتهای حکمرانی در سطح عالی متمرکز است. در حوزه EDM، COBIT اطمینان حاصل میکند که راهحلها و ابتکارات مرتبط با فناوری اطلاعات و فناوری (I&T) با اهداف استراتژیک سازمان همسو هستند. در این زمینه رهبری، اهداف، مقاصد و استراتژیهای I&T را تعیین میکند تا اطمینان حاصل شود که تمامی سرمایهگذاریها و تلاشهای فناوری به طور مستقیم به موفقیت کسبوکار کمک میکنند. همچنین، نظارت منظم بر عملکرد، یک جزء حیاتی از این حوزه است که به رهبری امکان میدهد ارزیابی کند آیا فناوری طبق انتظارات عمل میکند و ارزش مورد نظر را ارائه میدهد یا خیر. این همسویی مداوم بین فناوری و نتایج کسبوکار، اطمینان میدهد که سازمان یک جهتگیری استراتژیک روشن را با پشتیبانی از حکمرانی مؤثر و قابلاعتماد در مدیریت فناوری حفظ میکند.

- همسویی، برنامهریزی و سازماندهی (APO) - این حوزه به برنامهریزی استراتژیک راهحلها و ابتکارات فناوری میپردازد. تمرکز این حوزه بر توسعه سیاستهای فناوری اطلاعات، استراتژیهای مدیریت ریسک و برنامهریزی کلی منابع است تا اطمینان حاصل شود که سرمایهگذاریهای فناوری به شکلی ساختار یافتهاند که حداکثر ارزش را به ارمغان آورند. اهداف APO به سازمانها کمک میکنند تا سیستمهایی را طراحی کنند که به خوبی برنامهریزی شده و با اهداف تجاری همسو هستند و ظرفیت پشتیبانی از اهداف بلندمدت را دارند. با تمرکز بر نیازهای عملیاتی کوتاهمدت و اهداف استراتژیک بلندمدت، اهداف APO اطمینان میدهند که سیستمها با یک چشمانداز روشن از نقش خود در موفقیت سازمان پیادهسازی میشوند.

- ساخت، کسب و پیادهسازی (BAI) - در این حوزه، COBIT به جنبههای عملی توسعه و استقرار سیستمها و فناوریها میپردازد. این حوزه شامل هر سیستمی است که ساخته، بهدست آمده یا در کسبوکار ادغام شده است. اهداف BAI تضمین میکنند که توسعه و پیادهسازی مؤثر و کارآمد این سیستمها صورت گیرد و ریسکهای مرتبط با استقرارهای فناوری جدید به حداقل برسد. حوزه BAI تمام فعالیتهای لازم برای اطمینان از اینکه راهحلهای فناوری الزامات عملکرد را برآورده میکنند و بهگونهای مستقر میشوند که اختلال در عملیات جاری را به حداقل برسانند، پوشش میدهد.

- ارائه، خدمات و پشتیبانی (DSS) - این حوزه بر عملیات جاری فناوری و سیستمها پس از استقرار آنها تمرکز دارد. اهداف DSS به مدیریت ارائه خدمات فناوری اطلاعات میپردازند و اطمینان میدهند که این خدمات سطوح توافقشده از قبیل امنیت، تداوم سیستم و عملکرد را برآورده میکنند. همچنین، اهداف DSS تضمین میکنند که خدمات از طریق چارچوبهای امنیتی قوی و برنامههای تداوم حمایت میشوند تا زمان خرابی به حداقل برسد و به اختلالات احتمالی رسیدگی شود.

- نظارت، ارزیابی و سنجش (MEA) - این حوزه بر اهمیت بهبود مستمر در چارچوب حکمرانی I&T سازمان تأکید دارد. تمرکز این حوزه بر ارزیابی اثربخشی سیستمها و ساختارهای حکمرانی است تا اطمینان حاصل شود که آنها همچنان به برآورده کردن اهداف سازمانی و عملکرد مؤثر ادامه میدهند. از طریق ارزیابیهای منظم عملکرد و ارزیابیهای حکمرانی، اهداف MEA به سازمانها کمک میکنند تا زمینههای بهبود را شناسایی کرده، با نیازهای متغیر کسبوکار سازگار شوند و اطمینان حاصل کنند که فناوری با اهداف استراتژیک در حال تکامل سازمان همسو باقی میماند. این حلقه بازخورد مداوم برای حفظ یک سیستم حکمرانی I&T پویا و انعطافپذیر ضروری است. شکل ۲، ۴۰ هدف سازماندهی شده در پنج حوزه را نشان میدهد.

شکل 2: مدل اصلی COBIT

منبع: ISACA، چارچوب COBIT® 2019: مقدمه و روششناسی، ایالات متحده آمریکا، 2018

اجزای یک سیستم حکمرانی

هر سازمان برای دستیابی به اهداف حکمرانی و مدیریت خود، نیاز دارد که یک سیستم حکمرانی چندوجهی را ایجاد، سفارشیسازی و نگهداری کند. COBIT هفت جز را تعریف میکند که با همکاری یکدیگر، ابتکارات فناوری اطلاعات و تکنولوژی (I&T) را با اهداف تجاری همسو میکنند:

- فرایندها

- ساختارهای سازمانی

- اطلاعات

- افراد، مهارتها و شایستگیها

- اصول، سیاستها و رویهها

- فرهنگ، اخلاق و رفتار

- خدمات، زیرساختها و برنامهها

هر یک از این اجزا نقش مهمی در حمایت از اهداف حکمرانی و مدیریت دارند و با هم کار میکنند تا اطمینان حاصل کنند که سیستمها بهطور مؤثر در طول چرخه عمر خود مدیریت میشوند.

هوش مصنوعی به عنوان بخشی از اجزای خدمات، زیرساختها و برنامهها نشاندهنده یک پیشرفت کلیدی در فناوری است و باید با اجزای دیگر حکمرانی همسو شود. با این حال، بسیاری از سازمانها خدمات و برنامههای مبتنی بر هوش مصنوعی را بدون توجه به دیگر اجزای حکمرانی، مانند سیاستها، جریان اطلاعات، فرهنگ و اخلاق، توسعه میدهند.

فناوریهای هوش مصنوعی، مانند مدلهای یادگیری ماشین (ML)، الگوریتمهای تصمیمگیری و سیستمهای هوشمند، در این بخش قرار میگیرند. این فناوریها به عنوان زیرساختهای اصلی خدمات و برنامههای ضروری طراحی شدهاند که هدف آنها اتوماسیون، تصمیمگیری و ایجاد بینش است. با این حال، برای ادغام و بهرهبرداری موفق از آنها، وجود مکانیزمهای حکمرانی قوی الزامی است؛ زیرا نرمافزارها معمولاً بهروزرسانیهایی را ارائه میدهند که نیاز به ارزیابی مجدد دارند.

به علاوه، دیگر اجزای حکمرانی COBIT نقش مهمی در حمایت از حکمرانی هوش مصنوعی ایفا میکنند. فناوریهای هوش مصنوعی نمیتوانند بهطور مؤثر بهتنهایی عمل کنند. اجزای حکمرانی مؤثر در فعالسازی، پشتیبانی و تنظیم استفاده از این فناوریها شامل موارد زیر است:

- فرایندها: ساختارها و روشهای مشخص برای توسعه، استقرار و مدیریت فناوریهای هوش مصنوعی ضروری هستند. به عنوان مثال، یک فرایند قوی برای مدیریت چرخه عمر هوش مصنوعی میتواند تضمین کند که این سیستمها بهروز و همسو با اهداف تجاری باقی بمانند.

- اطلاعات: هوش مصنوعی برای عملکرد مؤثر خود به دادهها وابسته است. حکمرانی مناسب این اطمینان را میدهد که کیفیت دادهها مناسب باشد و حریم خصوصی و امنیت آنها رعایت شود. همچنین، باید از سوگیریها و نادرستیهایی که میتوانند عملکرد هوش مصنوعی را تحت تأثیر قرار دهند، جلوگیری شود.

- افراد، مهارتها و شایستگیها: داشتن متخصصان مجرب برای طراحی، پیادهسازی و نگهداری سیستمهای هوش مصنوعی بسیار مهم است. حکمرانی باید اطمینان حاصل کند که این متخصصان بهطور مداوم آموزش دیده و مهارتهایشان با نیازهای سازمان همراستا باشد.

- اصول، سیاستها و رویهها: وجود سیاستهای روشنی برای استفاده اخلاقی از هوش مصنوعی ضروری است. بهعنوان مثال، سازمانها باید دستورالعملهایی برای حفظ حریم خصوصی دادهها، شفافیت الگوریتمها و مسئولیتپذیری در تصمیمگیریهای مبتنی بر هوش مصنوعی تدوین کنند.

- فرهنگ، اخلاق و رفتار: این جزء نشاندهنده نحوه تعامل افراد و تیمها با سیستمهای هوش مصنوعی است. حکمرانی باید فرهنگ اعتماد و آگاهی اخلاقی را تقویت کند و اطمینان حاصل کند که فناوری با ارزشهای سازمان همسو است.

امروزه، بسیاری از سازمانها روی توسعه فناوریهای پیشرفته مانند هوش مصنوعی تمرکز میکنند، ولی ممکن است از نیاز به حکمرانی غفلت کنند.

امروزه، بسیاری از سازمانها روی توسعه فناوریهای پیشرفته مانند هوش مصنوعی تمرکز میکنند، ولی ممکن است از نیاز به حکمرانی غفلت کنند.

این بیتوجهی میتواند به مشکلات زیر منجر شود:

- نگرانیهای اخلاقی: مانند سوگیری در مدلهای هوش مصنوعی.

- ناکارآمدی: بهدلیل مراحل یا الزامات مبهم.

- مقاومت در برابر پذیرش: بهدلیل عدم تطابق با فرهنگ سازمانی.

یک رویکرد متعادل در حکمرانی میتواند تضمین کند که خدمات و زیرساختهای مبتنی بر هوش مصنوعی بهخوبی به اهداف تجاری کمک کنند و در عین حال به استانداردهای اخلاقی و سیاستهای سازمانی پایبند باشند. با توجه به تمام اجزای حکمرانی، سازمانها میتوانند خطرات را کاهش داده و از پتانسیل کامل هوش مصنوعی بهرهبرداری کنند.

تمام اجزای ذکرشده به یکدیگر وابستهاند و باید بهطور مشترک در نظر گرفته شوند، زیرا سازمانها در مراحل توسعه فناوری اطلاعات (IT) پیشرفت میکنند.

شکل 3: اجزای COBIT یک سیستم حکمرانی

منبع: ISACA، چارچوب COBIT® 2019: مقدمه و روششناسی، ایالات متحده آمریکا، 2018

ملاحظات طراحی سیستم راهبری

در طراحی سیستمهای راهبری، علاوه بر هفت مؤلفه اصلی، چارچوب COBIT به "آبشار اهداف" به عنوان یک عنصر کلیدی اشاره میکند. این آبشار به ۱۱ عامل طراحی مرتبط است که برای انتخاب مناسبترین اهداف راهبری و مدیریتی و همچنین هماهنگسازی فعالیتهای فناوری اطلاعات با اهداف کلی سازمان باید مورد توجه قرار گیرند. در نظر گرفتن اهداف سازمان و کاربرد آبشار اهداف، مرحلهای حیاتی در فرآیند طراحی سیستم راهبری است.

آبشار اهداف با شناسایی "محرکها و نیازهای ذینفعان" آغاز میشود. این محرکها شامل انتظارات ذینفعان، تقاضای بازار و عوامل خارجی هستند و مشخص میکنند که یک کسبوکار برای باقی ماندن در رقابت و افزایش کارایی به چه چیزهایی نیاز دارد.

نیازهای کسبوکار سپس به "اهداف سازمانی" ترجمه میشوند. COBIT ۱۳ هدفی کلی برای سازمانها تعریف کرده است که ابعاد مالی، مشتری، داخلی و رشد را شامل میشود. این اهداف به بهبود رضایت مشتری، بهینهسازی هزینهها و اطمینان از انطباق با مقررات مربوط میشوند.

"اهداف همسویی" به اهداف بزرگتر سازمان ارتباط دارند و پیوند اصلی را با اهداف راهبری و مدیریتی فراهم میکنند. این پیوند اطمینان میدهد که ابتکارات فناوری اطلاعات به موفقیت کسبوکار کمک کنند. اهداف همسویی نقشی اساسی در تعیین نحوه مدیریت سیستمها ایفا میکنند و اطمینان میدهند که سرمایهگذاریهای فناوری با اهداف سازمان هماهنگ باشد.

در نهایت، ۴۰ "هدف راهبری و مدیریتی" به سازمان در طراحی و پیادهسازی یک سیستم مؤثر برای مدیریت فرآیندهای فناوری اطلاعات و فناوری کمک میکنند.این مراحل اطمینان میدهند که تلاشهای تیمهای فناوری اطلاعات و راهبری بر فعالیتهایی تمرکز دارد که بهطور مستقیم حمایتکننده استراتژی کلی سازمان هستند. با رعایت این رویکرد، شرکتها میتوانند فعالیتهای راهبری فناوری اطلاعات خود را اولویتبندی کرده و منابع را به سمت فرآیندهایی اختصاص دهند که بیشترین تأثیر را در برآوردن نیازهای ذینفعان دارند. این مراحل همچنین میتوانند برای طراحی رویکردی هماهنگ در مدیریت هوش مصنوعی به کار روند.

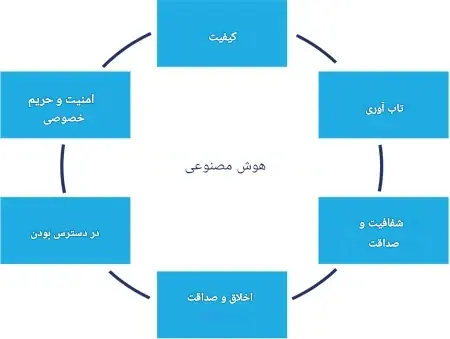

اصول هوش مصنوعی قابل اعتماد

هوش مصنوعی قابل اعتماد شامل اصولی است که به کاهش خطرات مرتبط با سیستمهای هوش مصنوعی کمک میکنند و اعتماد ذینفعان را افزایش میدهند، مانند شفافیت، پاسخگویی، انصاف، حریم خصوصی، قابلیت اطمینان، ایمنی، تابآوری و امنیت. استفاده از اهداف راهبری و مدیریتی COBIT در زمینه هوش مصنوعی در سطح سازمان، یک چارچوب جامع ایجاد میکند که از راهبری سطح بالا تا فرآیندها و سیستمهای عملیاتی را دربرمیگیرد. این رویکرد اطمینان میدهد که ابتکارات مرتبط با هوش مصنوعی بهطور کامل مدیریت میشوند و اهداف استراتژیک با اجرای عملیاتی همسو میشوند، در حالی که اصول هوش مصنوعی قابل اعتماد در هر سطح گنجانده میشوند. COBIT با پرداختن به جنبههای حکمرانی، سیاستگذاری، مدیریت ریسک و انطباق در سطوح بالا، و انتقال این اصول از طریق فرآیندها، نقشها و سیستمهای تعریفشده، به ادغام مؤثر هوش مصنوعی در اکوسیستم سازمان کمک میکند.

سفارشیسازی اهداف راهبری و مدیریتی COBIT برای اهداف هوش مصنوعی میتواند به سازمانها کمک کند تا رویکردی ساختاریافته برای مدیریت ریسکهای مرتبط با هوش مصنوعی طراحی کنند و در عین حال اطمینان حاصل کنند که این ابتکارات با اصول هوش مصنوعی قابل اعتماد هماهنگ هستند.

شکل ۴: عناصر هوش مصنوعی قابل اعتماد

منبع: ایساکا، "استفاده از چارچوب اکوسیستم اعتماد دیجیتال برای دستیابی به هوش مصنوعی قابل اعتماد"، 30 آوریل 2024، https://www.isaca.org/resources/white-papers/2024/using-dtef-to-achieve-trustworthy-ai

کیفیت داده برای اطمینان از اینکه مجموعههای داده حاوی اطلاعات دقیق هستند و سوگیریها شناسایی و کاهش مییابند، بسیار مهم است. سازمان باید اطمینان حاصل کند که معیارهای کیفی مشخصی وجود دارد و ارزیابیهای دورهای انجام میشود. ایمنی در سیستمهای هوش مصنوعی نیز با قابلیت اطمینان هوش مصنوعی مرتبط است، زیرا این ایمنی از کاربران و محیط زیست در برابر آسیبهای احتمالی ناشی از عملکرد سیستمهای هوش مصنوعی محافظت میکند.

- APO11 (کیفیت مدیریتشده) نیاز به مستندسازی را برای تشریح تضمین کیفیت و شیوههای ایمنی که برای سیستمهای هوش مصنوعی دنبال میشود، از جمله جنبههای مرتبط با داده پشتیبانی میکند.

- BAI03 (شناسایی و ساخت راهکارهای مدیریتشده) این اطمینان را فراهم میآورد که دادههای مورد استفاده برای ساخت مدلهای هوش مصنوعی، از کیفیت بالایی برخوردار، مرتبط و امن هستند.

تابآوری به توانایی یک سیستم هوش مصنوعی در انطباق با تغییرات یا اختلالات غیرمنتظره اشاره دارد. این تابآوری به کاهش احتمال شکست و واکنش مناسب پس از خرابی کمک میکند و به حفظ یکپارچگی عملیاتی کمک میکند. سیستمهای هوش مصنوعی انعطافپذیر میتوانند در برابر اختلالاتی مانند تغییرات داده یا حملات سایبری مقاومت کنند.

- سیستمهای هوش مصنوعی اغلب بهروزرسانیهای مکرر نیاز دارند، از تغییرات مدل گرفته تا تنظیمات الگوریتم. BAI06 (تغییرات فناوری اطلاعات مدیریتشده) از فرآیندهای مدیریت تغییرات ساختاریافته پشتیبانی میکند و اطمینان میدهد که اصلاحات سیستم هوش مصنوعی بهخوبی هماهنگ شدهاند تا اختلال را به حداقل برسانند و با اولویتهای تجاری همسو شوند.

شفافیت و صداقت در هوش مصنوعی به این معنی است که فرآیندها، تصمیمات و منابع داده سیستم بهطور واضح مستند شده و برای کاربران و ذینفعان قابل درک هستند. این امر مبنای هوش مصنوعی قابل توضیح (XAI) است و شرکتها باید به ارائه شواهدی که از آن پشتیبانی میکند، پاسخگو باشند. پاسخگویی همچنین موجب میشود افراد یا تیمهای تعیینشده مسئولیت حاکمیت سیستم هوش مصنوعی و نتایج آن، از جمله رسیدگی به هرگونه مشکلی که پیش میآید، را بر عهده بگیرند.

- EDM01 (تنظیم و نگهداری چارچوب حاکمیت تضمینشده) مستلزم ایجاد و اجرای یک چارچوب حاکمیتی است که نقشها را روشن کرده و پاسخگویی سازمانی را حفظ میکند. این هدف با نیاز به تعیین نظارت بر هوش مصنوعی همسو است و اطمینان میدهد که ساختارهای تصمیمگیری و پاسخگویی در سراسر تیمها ایجاد شده و قابل مشاهده هستند، بهویژه با توجه به وابستگیهای متقابل پیچیده هوش مصنوعی و الزامات داده.

اخلاق و یکپارچگی در هوش مصنوعی از نزدیک با انصاف در سیستمهای هوش مصنوعی همسو است. یک هدف کلیدی، جلوگیری از سوگیریها و اطمینان از رفتار عادلانه در میان گروههای مختلف کاربران است. این شامل کاهش سوگیریهای داده یا الگوریتمی است که میتواند منجر به نتایج تبعیضآمیز شود.

اخلاق و یکپارچگی در هوش مصنوعی از نزدیک با انصاف در سیستمهای هوش مصنوعی همسو است. یک هدف کلیدی، جلوگیری از سوگیریها و اطمینان از رفتار عادلانه در میان گروههای مختلف کاربران است. این شامل کاهش سوگیریهای داده یا الگوریتمی است که میتواند منجر به نتایج تبعیضآمیز شود.

این امر شامل کاهش سوگیریهای داده یا الگوریتمی است که میتواند منجر به نتایج تبعیضآمیز شود.

- EDM01 (تنظیم و نگهداری چارچوب حاکمیت تضمینشده) میتواند توسعه، استقرار و استفاده اخلاقی از فناوریهای هوش مصنوعی را با جهتگیری، اهداف و مقاصد شرکت همسو کند. سازمانها باید اطمینان حاصل کنند که سیستمهای هوش مصنوعی بهگونهای طراحی و مورد استفاده قرار میگیرند که ارزشهای اجتماعی را حفظ کنند، به محیط زیست طبیعی احترام بگذارند و به منافع و حقوق ذینفعان داخلی و خارجی توجه کنند. این شامل ترویج شفافیت، انصاف، پاسخگویی و فراگیری در فرآیندهای هوش مصنوعی برای کاهش سوگیریهای بالقوه، محافظت از حریم خصوصی و ترویج اعتماد به تصمیمگیری مبتنی بر هوش مصنوعی است.

- ملاحظات اخلاقی در هوش مصنوعی با APO01 (چارچوب مدیریت فناوری اطلاعات مدیریتشده) از COBIT همسو است. این چارچوب الزامی را ایجاد میکند که استراتژیهای فناوری، از جمله هوش مصنوعی، باید از استانداردهای اخلاقی پیروی کنند. EDM01 (تنظیم و نگهداری چارچوب حاکمیت تضمینشده) و EDM02 (تحویل مزایای تضمینشده) نیز با توجه به تأثیرات منفی احتمالی استفاده غیراخلاقی و پردازش داده بر جامعه و محیط زیست، و همچنین نظارت بر نتایج سیستمهای هوش مصنوعی برای اطمینان از همسویی آنها با موارد استفاده اخلاقی و ارزشهای سازمانی، از این اصول حمایت میکنند.

امنیت در هوش مصنوعی شامل اجرای تدابیر حفاظتی برای محافظت از سیستم هوش مصنوعی و دادههای آن در برابر دسترسیهای غیرمجاز و حملات است. سیستمهای هوش مصنوعی به کنترلهای امنیتی قوی نیاز دارند تا از بهرهبرداری از آسیبپذیریها جلوگیری کرده و یکپارچگی دادهها را تضمین کنند.

- با توجه به حساسیت هوش مصنوعی در برابر نقض دادهها و حملات خصمانه، DSS05 (خدمات مدیریت امنیت) به اجرای پروتکلهای امنیتی کمک میکند، در حالی که BAI09 (مدیریت داراییها) دستورالعملهایی را برای ایمنسازی زیرساختهای میزبانی سیستمهای هوش مصنوعی ارائه میدهد. این اهداف با هم، محیطهای امنی را برای ذخیرهسازی دادهها، آموزش مدل و عملیات ایجاد میکنند.

حریم خصوصی تضمین میکند که سیستمهای هوش مصنوعی از اطلاعات شخصی محافظت کرده و از مقررات مربوط به حفاظت از دادهها پیروی میکنند. این اصل به ویژه برای سیستمهای هوش مصنوعی که اطلاعات حساس یا قابل شناسایی را پردازش میکنند، بسیار مهم است.

- وجود یک استراتژی مؤثر برای مدیریت دادهها که نقشها و مسئولیتهای مربوط به مدیریت فراداده و کیفیت داده را مشخص کند، بسیار حائز اهمیت است. این استراتژی به حفاظت از مالکیت معنوی و دادههای حساس کمک میکند و با رویهها و فعالیتهای تعیین شده در APO14 (مدیریت داده) همسو است.

حفاظت از حریم خصوصی تضمین میکند که سیستمهای هوش مصنوعی از اطلاعات شخصی محافظت کرده و به مقررات مربوط به حفاظت از دادهها پایبند باشند. این اصل بهویژه برای سیستمهای هوش مصنوعی که اطلاعات حساس یا قابل شناسایی را مدیریت میکنند، اهمیت ویژهای دارد.

اهداف COBIT مرتبط با مدیریت مؤثر ریسک، انطباق با مقررات، تعامل با ذینفعان و نظارت بر کنترلهای داخلی، حمایت جامعی از تمام اصول هوش مصنوعی قابل اعتماد فراهم میآورند.

- در مورد ریسک، EDM03 (بهینهسازی ریسک تضمینشده) سازمانها را ملزم میکند که ریسکها را شناسایی، ارزیابی و مدیریت کنند. APO12 (ریسک مدیریتشده) با ایجاد ارزیابیهای ریسک ساختاریافته برای سیستمهای هوش مصنوعی و هدایت استراتژیهای کاهش ریسک این فرآیند را حمایت میکند. این دو هدف اطمینان میدهند که فرآیندهای مدیریت ریسک هوش مصنوعی با سطح تحمل ریسک کلی سازمان همسو و هماهنگ بوده و به کاهش ریسکهای خاص هوش مصنوعی کمک میکنند.

- در زمینه انطباق، MEA03 (انطباق مدیریتشده با الزامات خارجی)، APO14 (داده مدیریتشده) و APO11 (کیفیت مدیریتشده) راهنماییهای واضحی در مورد رعایت مقررات، کیفیت داده و حریم خصوصی ارائه میدهند. این اهداف اطمینان میدهند که سیاستهای حاکمیت داده از انطباق در تمامی حوزهها حمایت میکنند، بهویژه در زمینه مدیریت کیفیت داده و مسائل مربوط به حریم خصوصی که برای اخلاق هوش مصنوعی اساسی هستند.

- در زمینه انتظارات ذینفعان، EDM05 (تعامل ذینفعان تضمینشده) و APO04 (نوآوری مدیریتشده) بر اهمیت همسویی ابتکارات هوش مصنوعی با انتظارات ذینفعان تأکید دارند. این اهداف تضمین میکنند که حاکمیت هوش مصنوعی به نیازهای کاربران، از دپارتمانهای داخلی تا مشتریان خارجی، پاسخگو باشد، که این امر به تقویت اعتماد و همسویی با اهداف تجاری کمک میکند.

- در زمینه نظارت، روشهای MEA01 (مدیریت عملکرد و نظارت بر انطباق) را میتوان با تعیین اهداف نظارتی برای عملکرد هوش مصنوعی تسهیل کرد. همچنین، MEA02 (سیستم کنترل داخلی مدیریتشده) تضمین میکند که کنترلهای داخلی مانند بررسیهای امنیتی و انطباق به درستی پیادهسازی شدهاند، که این امکان را برای ارزیابیهای فوری و انجام اقدامات اصلاحی در صورت نیاز فراهم میکند.

برای اینکه بتوانید اهداف مدیریتی و حاکمیتی جامع و کاربردی را انتخاب کنید، هنگام به کارگیری هوش مصنوعی در سازمان، باید از راهنمای طراحی COBIT 2019 (به ویژه بخش “طراحی یک راه حل حاکمیت اطلاعات و فناوری” و جعبه ابزار طراحی ضمیمه آن) استفاده کنید. این راهنما به شما کمک می کند عوامل مهمی را در نظر بگیرید که بر پیاده سازی هوش مصنوعی تاثیر می گذارند. این عوامل طراحی شامل استراتژی شرکت، اهداف شرکت، مشخصات ریسک، مسائل مربوط به فناوری اطلاعات، چشم انداز تهدید، نیاز انطباق، نقش فناوری اطلاعات، مدل منبع یابی برای فناوری اطلاعات، روشهای پیادهسازی فناوری اطلاعات، استراتژی پذیرش فناوری و اندازه شرکت است.

کاربرد COBIT در چرخه عمر هوش مصنوعی

اصول COBIT را میتوان در تمام مراحل چرخه عمر هوش مصنوعی، از طراحی و توسعه تا استقرار، عملیات و نظارت، ادغام کرد تا حاکمیت و مدیریت فناوری هوش مصنوعی را بهبود بخشید.

به عنوان مثال، یک شرکت که میخواهد یک سیستم هوش مصنوعی داخلی بسازد، میتواند از حوزه EDM در COBIT استفاده کند تا مطمئن شود که ابتکارات هوش مصنوعی در مرحله طراحی با استراتژی کلی سازمان همسو هستند. اصول این حوزه به تصمیمگیرندگان کمک میکند تا تأثیر بالقوه هوش مصنوعی بر کسبوکار را ارزیابی کنند، منابع را به درستی تخصیص دهند و عملکرد را در برابر اهداف استراتژیک نظارت کنند. سازمانها همچنین از همان ابتدا، میتوانند از این اصول برای اطمینان از رعایت اصول استفاده اخلاقی، عدالت و شفافیت در سیستمهای هوش مصنوعی خود، استفاده کنند.

در مرحله توسعه، حوزه APO به سازمانها کمک میکند تا ساختارهای مدیریتی مشخصی را تعریف کنند و فرآیندهای لازم برای ساخت سیستمهای هوش مصنوعی امن و قابل اعتماد را ایجاد کنند. این اصول برای سازمانهایی که سیستمهای هوش مصنوعی را خریداری میکنند نیز به همان اندازه مهم هستند. این مرحله شامل تعیین سیاستهای روشن برای حاکمیت داده، امنیت و انطباق، برنامهریزی برای نیازهای منابع ابتکار هوش مصنوعی و اطمینان از رفع مشکلات تعصب، آسیبپذیریهای امنیتی و چالشهای انطباق است.

در مرحله استقرار، میتوان از حوزه BAI در COBIT استفاده کرد تا نحوه ادغام سیستمهای هوش مصنوعی در کسبوکار را بررسی کرد. صرف نظر از اینکه سازمان سیستم هوش مصنوعی را میخرد یا میسازد، این حوزه تضمین میکند که به طور ایمن و کارآمد پیادهسازی شده و فرآیندهای آزمایش و اعتبارسنجی مناسب در جای خود قرار دارند. این حوزه همچنین جنبههایی از مدیریت تغییر را پوشش میدهد و اطمینان میدهد که راهکارهای جدید هوش مصنوعی بدون ایجاد اختلال در سیستمهای موجود یا ایجاد ریسکهای پیشبینینشده، معرفی میشوند.

هنگامی که یک سیستم هوش مصنوعی مستقر شد، حوزه DSS عملیات روزمره و پشتیبانی مداوم از راهکار هوش مصنوعی را پوشش میدهد. اصول DSS تضمین میکند که سیستمهای هوش مصنوعی به طور کارآمد عمل میکنند، سطوح خدمات حفظ میشوند و هرگونه مشکل به سرعت برطرف میشود. این حوزه همچنین امنیت و تداوم سیستمهای هوش مصنوعی را برای محافظت از آنها در برابر تهدیدات سایبری و سایر ریسکها در حین عملیات تضمین میکند.

اصول DSS تضمین میکند که سیستمهای هوش مصنوعی به طور کارآمد عمل میکنند، سطوح خدمات حفظ میشوند و هرگونه مشکل به سرعت برطرف میشود.

در نهایت، در مرحله نظارت، حوزه MEA در COBIT از ارزیابی مداوم سیستمهای هوش مصنوعی پشتیبانی میکند تا اطمینان حاصل شود که اهداف عملکرد، انطباق و مدیریت ریسک را برآورده میکنند. این حوزه بر اهمیت ارزیابی نتایج هوش مصنوعی، اندازهگیری عملکرد در برابر اهداف تجاری و شناسایی زمینههای بهبود تأکید دارد. اصول MEA همچنین نقش مهمی در تضمین انطباق سیستمهای هوش مصنوعی با مقررات و استانداردهای صنعت ایفا میکنند. از طریق نظارت و ارزیابی مداوم، سازمانها میتوانند مدلها و فرآیندهای هوش مصنوعی را بهبود بخشند تا از موفقیت بلندمدت و همسویی با اهداف داخلی و الزامات خارجی اطمینان حاصل کنند.

نمونه موردی استفاده

یک شرکت تجارت الکترونیک جهانی را در نظر بگیرید که میخواهد یک سیستم خدمات مشتری مبتنی بر هوش مصنوعی را پیادهسازی کند تا رضایت مشتریان را افزایش داده و هزینههای عملیاتی را کاهش دهد. رهبران این شرکت نیازهای کلیدی ذینفعان را شناسایی کردهاند که شامل نیاز به زمان پاسخگویی سریعتر، تعامل بیشتر با مشتری و برقراری تعاملات شخصیتر است. با این حال، سازمان همچنین به خطرات مرتبط با هوش مصنوعی (مانند سوگیری احتمالی در تعاملات با مشتری)، رعایت مقررات (به ویژه در مورد دادههای مشتری) و نیاز به پشتیبانی مداوم برای حفظ عملکرد سیستم هوش مصنوعی توجه دارد.

برای اطمینان از موفقیت این ابتکار هوش مصنوعی، شرکت اصول COBIT را برای ترجمه نیازهای ذینفعان به اهداف عملیاتی و فناوری اطلاعات (I&T) بهکار میگیرد. محرکهای اصلی شامل تقاضای مشتریان برای خدمات سریعتر و کارآمدتر، نیاز مدیریت به کاهش هزینههای عملیاتی و رعایت قوانین حریم خصوصی دادهها (مانند GDPR) هستند. ذینفعان نیز انتظار دارند که تعاملات هوش مصنوعی بهطور اخلاقی و بدون سوگیری انجام شوند.

بر اساس این محرکها، سازمان اهدافی را شناسایی میکند که شامل بهبود خدمات مشتریمحور، بهینهسازی تداوم و در دسترس بودن کسبوکار و حفظ انطباق با قوانین و مقررات است. این اهداف به اهداف خاص I&T مرتبط میشوند که مستقیماً از اولویتهای تجاری سازمان حمایت میکنند.

گام بعدی ترجمه و همسو کردن اهداف سازمان با اهداف ویژه فناوری اطلاعات است. در این پروژه هوش مصنوعی، اهداف شامل اطمینان از عملکرد بالا و قابلیت اطمینان سیستمهای هوش مصنوعی، بهینهسازی تجربه مشتری از طریق شخصیسازی و رعایت مقررات امنیت و حریم خصوصی دادهها است.

در نهایت، اهداف بیشتر به اهداف خاص حکومتی و مدیریتی تقسیم میشوند که پیادهسازی، نظارت و بهبود مستمر سیستم هوش مصنوعی را راهنمایی میکنند.

پس از تعیین اولویتها، شرکت از اهداف COBIT برای ساختاربندی حاکمیت سیستم خدمات مشتری مبتنی بر هوش مصنوعی خود استفاده میکند. این اهداف با تعریف فرآیندهای خاص حکومتی و مدیریتی برای راهنمایی در توسعه، استقرار و نظارت مستمر سیستم هوش مصنوعی آغاز میشوند. به عنوان مثال، فرآیندی برای آزمایش و اعتبارسنجی مدل هوش مصنوعی تنظیم میشود تا اطمینان حاصل شود که خروجیهای آن (تعاملات با مشتری) دقیق، بدون سوگیری و همسو با استانداردهای شرکت برای خدمات مشتری (مانند BAI03.06) هستند. این فرآیند شامل آموزش مجدد منظم مدل هوش مصنوعی برای در نظر گرفتن نیازهای در حال تحول مشتریان یا تغییرات زبانی در بازارهای جهانی میشود.

این شرکت سیاستهای حاکمیت دادهای را پیادهسازی میکند که اطمینان حاصل میکند اطلاعات مشتری بهصورت ایمن پردازش شده و با قوانین GDPR و مقررات مشابه مطابقت دارد. دادههای مورداستفاده برای آموزش مدل هوش مصنوعی بهطور منظم از نظر کیفیت، دقت و انصاف بررسی میشوند، تا از وقوع تعاملات جانبدارانه که ممکن است به تجربه مشتری آسیب برساند، جلوگیری شود (به عنوان مثال، MEA04.06). همچنین، شرکت مجموعهای از سیاستها و رویهها را برای حاکمیت استفاده روزمره از سیستم هوش مصنوعی ایجاد میکند؛ این سیاستها شامل نحوه ثبت تمام تعاملات مبتنی بر هوش مصنوعی و رویههای مرتبط با بهروزرسانی یا اصلاح سیستم هوش مصنوعی است.

علاوه بر این، شرکت یک ساختار حاکمیتی پایهگذاری میکند که شامل چندین ذینفع، مانند کمیته راهبری هوش مصنوعی در سطح هیئت مدیره است. این کمیته نمایندگان مدیران فناوری اطلاعات، افسران انطباق و حریم خصوصی، رهبران خدمات مشتری و دانشمندان داده را در بر میگیرد (به عنوان مثال، EDM05.01). مسئولیتها در این ساختار از طریق نمودار RACI مشخص میشود، تا هر نهاد تصمیمگیرنده از وظایف خود در قبال سیستم هوش مصنوعی آگاه باشد. در این راستا، مدیران فناوری اطلاعات مسئول اطمینان از عملکرد فنی سیستم هستند، در حالی که افسران انطباق و حریم خصوصی، پایبندی به مقررات حریم خصوصی دادهها را نظارت میکنند. رهبران خدمات مشتری بر اساس تجربیات کاربران، بازخوردهایی درباره عملکرد سیستم هوش مصنوعی ارائه میدهند. همچنین، برنامههای آموزشی مستمر برای بهروز نگهداشتن همه تیمها در خصوص روندهای جدید هوش مصنوعی، الزامات حاکمیتی، نگرانیهای اخلاقی و آخرین پیشرفتها در این زمینه اجرا میشوند (به عنوان مثال، APO04.04).

این سازمان فرهنگ استفاده مسئولانه از هوش مصنوعی و برقراری تعاملات اخلاقی با مشتری را ترویج میکند. رهبری این شرکت بر اهمیت شفافیت در نحوه تصمیمگیری سیستم هوش مصنوعی تأکید دارد، تا مشتریان بتوانند بفهمند چگونه و چرا نتایج خاصی (مانند پاسخ به پرسشها) تولید میشوند. این شرکت با برگزاری برنامههای آموزشی، به کارمندان کمک میکند تا پیامدهای تأثیر هوش مصنوعی بر تعاملات مشتری را درک کنند و رفتارهای اخلاقی را تشویق میکند.

در نهایت، شرکت در یک زیرساخت ابری قوی سرمایهگذاری میکند تا از سیستم هوش مصنوعی حمایت کند (به عنوان مثال، APO03). این اقدام تضمین میکند که سیستم بتواند بهخوبی با نیازهای عملیات جهانی سازگار شود و در عین حال امنیت و عملکرد خود را حفظ کند (به عنوان مثال، BAI04). همچنین، نگهداری و بهروزرسانیهای منظم برنامهریزی شده است تا اطمینان حاصل شود که برنامه هوش مصنوعی همواره با نیازهای تجاری همسو باقی میماند و به ارائه خدمات قابل اعتماد به مشتریان ادامه میدهد.

چالش ها و ملاحظات

سازمان ها ممکن است در هنگام ادغام هوش مصنوعی در شیوه های حکمرانی و مدیریت خود با چندین چالش روبرو شوند، که عمدتاً ناشی از پیچیدگی، تحول سریع و الزامات یکپارچه سازی هوش مصنوعی است. عدم وجود مالکیت مشخص بر حکمرانی هوش مصنوعی اغلب منجر به نظارت پراکنده و دشواری در همسویی سیستم های هوش مصنوعی با استراتژی کلی کسب و کار می شود. پیادهسازی کامل چارچوبهای حکمرانی سنتی در زمینه هوش مصنوعی میتواند دشوار باشد، بهویژه اینکه سیستمهای هوش مصنوعی اغلب بهصورت مجزا و جدا از زیرساختهای فناوری اطلاعات سنتی عمل میکنند.

عدم وجود مالکیت مشخص بر حکمرانی هوش مصنوعی اغلب منجر به نظارت پراکنده و دشواری در همسویی سیستم های هوش مصنوعی با استراتژی کلی کسب و کار می شود.

علاوه بر این، هوش مصنوعی خطرات خاصی مانند سوگیری و نگرانیهای اخلاقی را به همراه دارد که نیازمند مدلهای حکمرانی تخصصیتری هستند. ادغام این خطرات در چارچوب مدیریت ریسک جامع COBIT میتواند پیچیده باشد و ممکن است به سفارشیسازی قابل توجهی نیاز داشته باشد.

سازمان باید نمایه ریسک خود را بررسی کند که این کار به یک تحلیل کلی برای شناسایی سناریوهای ریسک مرتبط نیاز دارد. همچنین باید تأثیر و احتمال وقوع هر سناریو، با توجه به کنترلهای موجود برای کاهش ریسک، ارزیابی شود تا ارزیابی مؤثری از ریسک انجام شود. نمونههایی از دستههای ریسک مرتبط با هوش مصنوعی که سازمان باید به آنها توجه کند در شکل ۵ موجود است.

شکل 5: دستههای ریسک هوش مصنوعی

|

دستهبندی ریسک |

نمونه سناریوی ریسک |

|

ریسک استفاده اخلاقی |

سوگیری و تبعیض—سیستمهای هوش مصنوعی ناخواسته سوگیریها را در دادههای آموزشی تقویت میکنند و منجر به رفتار ناعادلانه با گروههای خاص میشوند (به عنوان مثال، توصیههای استخدامی مغرضانه). پیامدهای ناخواسته—سیستمهای هوش مصنوعی به روشهایی که توسعهدهندگان پیشبینی نمیکنند یاد میگیرند و عمل میکنند، که به طور بالقوه منجر به نتایج مضر میشود |

|

ریسک سیاست و حکمرانی

|

فقدان پاسخگویی—مالکیت تعریفنشده تصمیمات هوش مصنوعی منجر به عدم پاسخگویی مشخص در هنگام بروز خطاها یا آسیب میشود. عدم انطباق با استانداردهای جهانی—سیستمهای هوش مصنوعی نمیتوانند الزامات نظارتی فرامرزی را برآورده کنند (به عنوان مثال، GDPR، قانون هوش مصنوعی اتحادیه اروپا)، که منجر به جریمه یا تأخیر در عملیات میشود.

|

|

ریسک فناوری و زیرساخت

|

شکستهای الگوریتمی—مدلهای هوش مصنوعی به دلیل خطا در طراحی، داده یا استقرار، پیشبینیها یا طبقهبندیهای نادرستی تولید میکنند. حملات خصمانه—هکرها ورودیهای هوش مصنوعی (به عنوان مثال، تصاویر یا متن) را دستکاری میکنند تا از نقاط ضعف سوء استفاده کرده و نتایج دلخواه را تولید کنند.

|

|

ریسک عملیاتی و سازمانی

|

اتکای بیش از حد به هوش مصنوعی—کارمندان بدون نظارت انتقادی بیش از حد به خروجیهای هوش مصنوعی تکیه میکنند و منجر به اعتماد کورکورانه به سیستمهای معیوب میشوند. عدم همسویی با اهداف استراتژیک—سرمایهگذاریهای هوش مصنوعی به جای حل مشکلات واقعی کسب و کار، بر فناوریهای پرطرفدار تمرکز دارند.

|

|

ریسک نوظهور و استراتژیک

|

سوء استفاده از هوش مصنوعی مولد—هوش مصنوعی مولد محتوای مضر (به عنوان مثال، تصاویر صریح یا تبلیغات افراطی) ایجاد میکند که بر اعتبار برند تأثیر میگذارد. سابقه حقوقی علیه هوش مصنوعی—دادخواستها یا احکام قانونی جدید نحوه استقرار یا استفاده سازمانها از سیستمهای هوش مصنوعی را محدود میکند. |

یکی از چالشهای مهم در زمینه هوش مصنوعی، جلب مشارکت ذینفعان امنیتی است. از آنجا که پروژههای هوش مصنوعی معمولاً شامل تیمهای فنی متخصص هستند، ذینفعان غیر فنی ممکن است به طور کامل نتوانند الزامات حاکمیت هوش مصنوعی را درک کنند. این موضوع همکاری بین بخشی و کسب تخصصهای مورد نیاز در تیم حاکمیت را دشوار میسازد.

همچنین، حاکمیت هوش مصنوعی به مشارکت فعال رهبری ارشد و معیاری مؤثر برای سنجش فرآیندهای حاکمیتی نیاز دارد تا اطمینان حاصل شود که این فرآیندها با اهداف تجاری همسو هستند. بدون حمایت از سوی رهبری، ابتکارات حاکمیت هوش مصنوعی ممکن است منابع و توجه کافی نداشته باشند که به تلاشهای پراکندهای منجر میشود و موفقیت ادغام هوش مصنوعی را تضعیف میکند.

برای غلبه بر این چالشها، سازمانها باید جلب حمایت اجرایی را در اولویت قرار دهند و بر همسویی بین ابتکارات فناوری اطلاعات (I&T) و هوش مصنوعی با اهداف تجاری تأکید کنند. این کار تضمین میکند که تلاشهای حاکمیت هوش مصنوعی منابع و توجه لازم را از سوی رهبری دریافت میکنند. همچنین، تقویت همکاری بین بخشهایی همچون فناوری اطلاعات، علم داده، انطباق و حقوقی، برای ایجاد یک چارچوب حاکمیت یکپارچه که به خطرات خاص هوش مصنوعی رسیدگی کند، ضروری است.

در نهایت، با توجه به تکامل سریع فناوریهای هوش مصنوعی، آموزش مداوم بسیار اهمیت دارد. سازمانها باید اطمینان حاصل کنند که تیمهای فنی و غیر فنی از روندها و خطرات جدید مطلع هستند و قادرند ساختارهای حاکمیتی خود را در چارچوب COBIT بهروز کنند تا بهطور مؤثر با چالشهای جدید هوش مصنوعی که به وجود میآید، مدیریت کنند.

مزایای استفاده از COBIT برای فناوری هوش مصنوعی

با استفاده از COBIT، سازمانها میتوانند اطمینان حاصل کنند که ابتکارات هوش مصنوعی با استراتژیهای کلی آنها همسو هستند. COBIT به شکلگیری یک سیستم حاکمیتی کمک میکند که اهداف هوش مصنوعی را به طور مستقیم با اهداف تجاری همراستا میکند. با بهرهگیری از اصول COBIT، پروژههای هوش مصنوعی به گونهای طراحی میشوند که تمرکز روشنی بر همسویی استراتژیک داشته باشند و اطمینان حاصل میشود که همه فعالیتها—از توسعه تا استقرار—به هدف خدمت به مأموریت اصلی سازمان و همسویی با استراتژیهای کلان آن طراحی شدهاند. این همسویی به ایجاد ارزش قابل اندازهگیری کمک کرده و سازمانها را قادر میسازد تا به نتایج مشخص و قابل اندازهگیری، از جمله افزایش بهرهوری عملیاتی، بازگشت مثبت سرمایه (ROI)، بهبود تصمیمگیری و ارتقاء تعامل با مشتری دست یابند.

COBIT همچنین بر اهمیت پاسخگویی تأکید میکند و تضمین میکند که هر ابتکار هوش مصنوعی دارای مالکیت مشخصی باشد و یک نقشهراه برای دستیابی به نتایج تجاری تعریف شده داشته باشد. به این ترتیب، سازمانها میتوانند از سرمایهگذاریهای هوش مصنوعی خود به شکل مؤثرتری بهرهبرداری کرده و در صنعت خود رقابتیتر شوند.

فناوریهای هوش مصنوعی با چالشهای خاصی همراه هستند، اما COBIT یک چارچوب قوی برای شناسایی، ارزیابی و کاهش این ریسکها در طول چرخه حیات هوش مصنوعی ارائه میدهد. استفاده از COBIT الزامی میکند که ارزیابی کاملی از ریسکها صورت گیرد که عواملی همچون یکپارچگی دادهها، سوگیری مدلها و انطباق با مقررات را در نظر بگیرد. این رویکرد به مرحله استقرار نیز گسترش مییابد، زمانی که نظارت مستمر برای شناسایی تهدیدات بالقوه یا آسیبپذیریهای امنیتی امری حیاتی میشود.

COBIT ارزیابی و کاهش ریسکها در طول چرخه حیات هوش مصنوعی ارائه میدهد. با پیادهسازی دستورالعملهای مدیریت ریسک COBIT، سازمانها میتوانند به صورت سیستماتیک ریسکها را مدیریت کرده و کاهش دهند و از این طریق اطمینان حاصل میکنند که سیستمهای هوش مصنوعی قابل اعتماد، سازگار و از لحاظ اخلاقی سالم باقی بمانند. علاوه بر این، تمرکز COBIT بر ارزیابی عملکرد، انطباق و نظارت، تضمین میکند که هر ریسک نوظهور به سرعت شناسایی و کاهش یابد تا از اختلالات احتمالی در سازمان جلوگیری شود.

سیستمهای هوش مصنوعی به منابع مختلفی نیاز دارند، از جمله دادههای با کیفیت بالا، پرسنل ماهر و زیرساخت فناوری قوی. COBIT به سازمانها کمک میکند تا این منابع را بهطور کارآمد مدیریت کنند و از اتلاف آنها جلوگیری کرده و حداکثر بازگشت سرمایه (ROI) را به دست آورند.

COBIT در تخصیص مؤثر دادهها نیز نقش دارد و اطمینان میدهد که فقط دادههای مرتبط و با کیفیت بالا در مدلهای هوش مصنوعی مورد استفاده قرار میگیرند. همچنین، دستورالعملهایی برای استخدام و نگهداری استعدادهایی که دارای مهارتهای تخصصی لازم برای توسعه هوش مصنوعی هستند، از جمله دانشمندان داده و مهندسان یادگیری ماشین، ارائه میدهد. COBIT همچنین مقیاسپذیری را ترویج میکند با اطمینان از این که سرمایهگذاریهای زیرساختی و فناوری با تقاضای فعلی و آینده سازگار هستند. این رویکرد آیندهنگر به سازمانها کمک میکند تا از هزینههای غیرضروری اجتناب کنند و آنها را برای مقیاسبندی ابتکارات هوش مصنوعی مطابق با تکامل نیازهای سازمان آماده میسازد، در حالی که کنترل هزینهها نیز حفظ میشود.

علاوه بر این، چارچوب حاکمیتی COBIT بر بهبود مستمر تأکید دارد؛ این موضوع برای سیستمهای هوش مصنوعی که به انطباق با محیطهای تجاری متغیر و پیشرفتهای فناوری نیاز دارند، ضروری است. COBIT با گنجاندن شیوههای نظارت و ارزیابی مداوم، تضمین میکند که سیستمهای هوش مصنوعی بهطور مداوم تحت ارزیابی معیارهای عملکرد، استانداردهای انطباق و الزامات تجاری در حال تحول قرار میگیرند. این شیوهها باعث میشوند که سازمانها بتوانند نقاط ضعف عملکرد را شناسایی کرده، با روندهای نوظهور سازگار شوند و بازخوردها را در چرخه حیات سیستم هوش مصنوعی لحاظ کنند.

COBIT همچنین به تشویق یک حلقه بازخورد میپردازد که شامل ذینفعان از بخشهای مختلف سازمان است و دیدگاه جامعتری از تأثیر سیستمهای هوش مصنوعی بر سازمان ارائه میدهد. این چرخه بهبود مستمر اطمینان میدهد که سیستمهای هوش مصنوعی در طول زمان مرتبط، مؤثر و همسو با استراتژی سازمان باقی بمانند. علاوه بر این، اصول حاکمیتی COBIT سازمانها را در مستندسازی این پیشرفتها راهنمایی میکند و فرهنگ شفافیت و پاسخگویی را تقویت میکند؛ این امر اعتماد به سیستمهای هوش مصنوعی را در تمام سطوح سازمان افزایش میدهد.

نتیجهگیری

بهرهگیری از COBIT برای حاکمیت و مدیریت هوش مصنوعی، به سازمانها یک رویکرد ساختاریافته و جامع ارائه میدهد تا سیستمهای هوش مصنوعی را با اهداف استراتژیک خود همسو کنند، از شیوههای مسئولانه و اخلاقی هوش مصنوعی اطمینان حاصل نمایند و ریسکهای منحصر به فرد مرتبط با هوش مصنوعی را کاهش دهند. با ادغام اصول حاکمیتی COBIT در سراسر چرخه عمر هوش مصنوعی—از همسویی استراتژیک و مدیریت ریسک گرفته تا بهبود مستمر—سازمانها میتوانند بهطور مؤثرتری با پیچیدگیهای پیادهسازی هوش مصنوعی مقابله کنند. چارچوب COBIT نهتنها به بهینهسازی منابع و افزایش پاسخگویی کمک میکند، بلکه پایهای از اعتماد را در ابتکارات هوش مصنوعی ایجاد مینماید.

از طریق COBIT، سازمانها بهطور بهتری قادر خواهند بود چالشهای پذیرش هوش مصنوعی را در یک چشمانداز به سرعت در حال تغییر مدیریت کنند و در عین حال ارزش پایدار را ایجاد کرده و تابآوری را در عملیات مبتنی بر هوش مصنوعی تقویت نمایند.

منبع: ترجمه مقاله ی Leveraging COBIT for Effective AI System Governance

استفاده از COBIT برای مدیریت موثر سیستم هوش مصنوعی